Última actualización: enero 30, 2022

13.0. Introducción

13.0.1. ¿Por qué debería tomar este módulo?

¡Bienvenido a Virtualización de la Red!

Imagine que vive en una casa de dos dormitorios. Usan el segundo dormitorio como almacenamiento. El segundo dormitorio está lleno de cajas, pero todavía tiene más que colocar en el almacenamiento! Podría considerar construir una adición en su casa. Sería un esfuerzo costoso y puede que no necesite tanto espacio para siempre. Usted decide alquilar una unidad de almacenamiento para el desbordamiento.

Al igual que una unidad de almacenamiento, la virtualización de red y los servicios en la nube pueden proporcionar a una empresa opciones distintas de agregar servidores a su propio centro de datos. Además del almacenamiento, ofrece otras ventajas. Comience con este módulo para obtener más información sobre lo que la virtualización y los servicios en la nube pueden hacer.

13.0.2. ¿Qué aprenderá en este módulo?

Título del módulo: Virtualización de la red

Objetivos del módulo: Explique el propósito y las características de la virtualización de la red.

| Título del tema | Objetivo del tema |

|---|---|

| Computación en la nube | Explique la importancia de la computación en la nube. |

| Virtualización | Explique la importancia de la virtualización. |

| Infraestructura de red virtual | Describa la virtualización de los servicios y dispositivos de red. |

| Redes definidas por software | Describa las redes definidas por software. |

| Controladores | Describa los controladores utilizados en la programación de redes. |

13.1. Computación en la nube

13.1.1. Video: La nube y Virtualización

Haga clic en Reproducir para ver una descripción general de la computación en la nube y la virtualización.

13.1.2. La nube: descripción general

En el video anterior, se explicó una visión general de la computación en la nube. La computación en la nube implica una gran cantidad de computadoras conectadas a través de una red que puede estar ubicada físicamente cualquier lugar. Los proveedores confían mucho en la virtualización para prestar servicios de computación en la nube. La computación en la nube puede reducir costos operativos al utilizar los recursos con mayor eficacia. La computación en la nube aborda una variedad de problemas de administración de datos:

- Permite el acceso a los datos de organización en cualquier momento y lugar.

- Optimiza las operaciones de TI de la organización suscribiéndose únicamente a los servicios necesarios.

- Elimina o reduce la necesidad de equipos, mantenimiento y administración de TI en las instalaciones.

- Reduce el costo de equipos y energía, los requisitos físicos de la planta y las necesidades de capacitación del personal.

- Permite respuestas rápidas a los crecientes requisitos de volumen de datos.

La computación en la nube, con su modelo de “pago según el consumo”, permite que las organizaciones consideren los gastos de computación y almacenamiento más como un servicio que como una inversión en infraestructura. Los gastos de capital se transforman en gastos operativos.

13.1.3. Servicios en la nube

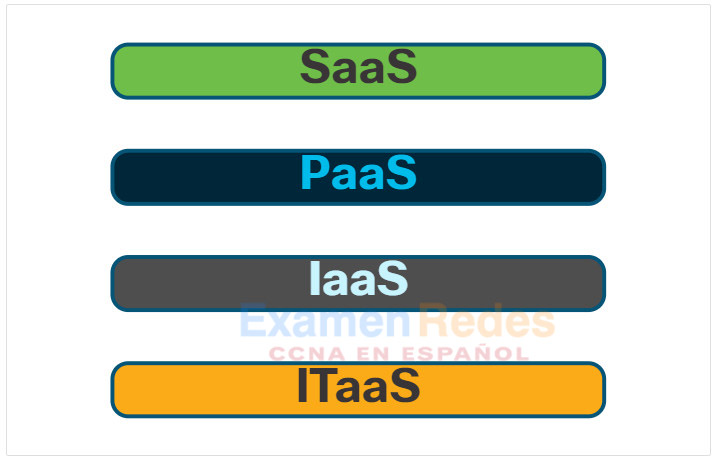

Los servicios en la nube están disponibles en una variedad de opciones diseñadas para cumplir con los requisitos del cliente. Los tres servicios principales de computación en la nube definidos por el Instituto Nacional de Normas y Tecnología (NIST) de los Estados Unidos en la Publicación especial 800-145 son:

- Software como servicio (SaaS) – El proveedor de la nube es responsable del acceso a los servicios, como correo electrónico, comunicaciones y Office 365, que se proporcionan por Internet. El usuario no administra ningún aspecto de los servicios en la nube, excepto la configuración limitada de la aplicación específica del usuario. El usuario sólo necesita proporcionar sus datos.

- Plataforma como un Servicio (PaaS) – El proveedor de la nube es responsable del acceso a las herramientas y los servicios de desarrollo utilizados para distribuir las aplicaciones. Estos usuarios suelen ser programadores y pueden tener control sobre la configuración del entorno de alojamiento de aplicaciones del proveedor de nube.

- Infraestructura como servicio (IaaS) – El proveedor de la nube es responsable del acceso a los equipos de la red, los servicios de red virtualizados y el soporte de infraestructura de la red. El uso de este servicio en la nube permite a los administradores de TI implementar y ejecutar código de software, que puede incluir sistemas operativos y aplicaciones.

Los proveedores de servicios en la nube han ampliado este modelo para proporcionar también soporte de TI para cada uno de los servicios de computación en la nube (ITaaS), como se muestra en la figura. Para las empresas, ITaaS puede ampliar la capacidad de la red, sin requerir inversiones en nueva infraestructura, capacitación de personal, ni licencias de software nuevas. Estos servicios están disponibles a petición y se proporcionan de forma económica a cualquier dispositivo en cualquier lugar del mundo, sin comprometer la seguridad ni el funcionamiento.

13.1.4. Modelos de nube

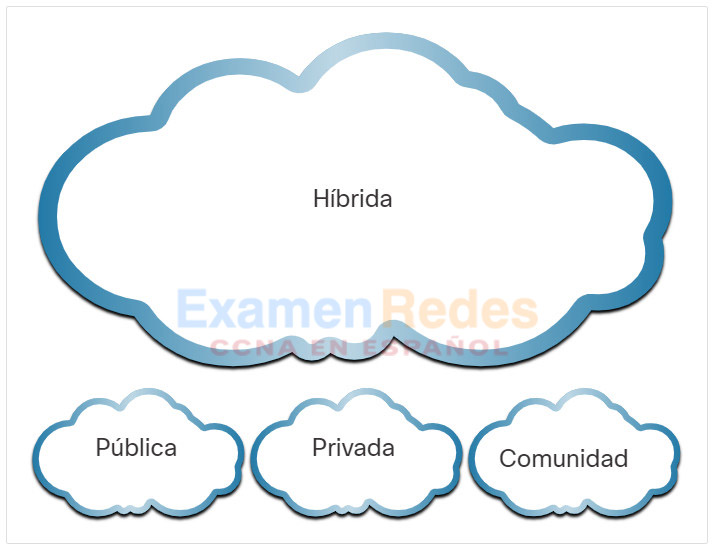

Hay cuatro modelos principales de nube, como se muestra en la figura.

- Nubes públicas – Las aplicaciones basadas en la nube y los servicios que se ofrecen en una nube pública están a disposición de la población en general. Los servicios pueden ser gratuitos u ofrecerse sobre la base de pago por utilización, como el pago por almacenamiento en línea. La nube pública utiliza Internet para proporcionar servicios.

- Nubes privadas – Las aplicaciones y los servicios basados en una nube privada que se ofrecen en una nube privada están destinados a una organización o una entidad específica, como el gobierno. Se puede configurar una nube privada utilizando la red privada de la organización, si bien el armado y el mantenimiento pueden ser costosos. Una organización externa que cuente con una seguridad de acceso estricta también puede administrar una nube privada.

- Nubes híbridas: consta de dos o más nubes (por ejemplo: parte privada, parte pública), donde cada parte sigue siendo un objeto separado, pero ambos están conectados mediante una sola arquitectura. En una nube híbrida, las personas podrían tener grados de acceso a varios servicios según sus derechos de acceso de usuario.

- Nubes comunitarias – Una nube comunitaria se crea para el uso exclusivo de una comunidad específica. Las diferencias entre nubes públicas y las comunitarias son las necesidades funcionales que han sido personalizadas para la comunidad. Por ejemplo, las organizaciones de servicios de salud deben cumplir las políticas y leyes (por ejemplo, la HIPAA) que requieren una autenticación y una confidencialidad especiales.

13.1.5. Computación en la nube frente al centro de datos

Los términos «centro de datos» y «computación en la nube» suelen usarse de manera incorrecta. A continuación se brindan las definiciones correctas de «centro de datos» y «computación en la nube»:

- Data center: Por lo general, una instalación de almacenamiento y procesamiento de datos administrada por un departamento de TI interno o arrendado fuera del sitio.

- Computación en la nube: Por lo general, un servicio fuera de las instalaciones que ofrece acceso a pedido a un grupo compartido de recursos informáticos configurables. Estos recursos se pueden aprovisionar y liberar rápidamente con un esfuerzo de administración mínimo.

Los centros de datos son las instalaciones físicas que proporcionan las necesidades informáticas, de red y de almacenamiento de los servicios de computación en la nube. Los proveedores de servicios en la nube usan los centros de datos para alojar los servicios en la nube y los recursos basados en la nube.

Un centro de datos puede ocupar una habitación en un edificio, un piso o más, o un edificio entero. Por lo general, la creación y el mantenimiento de centros de datos son muy costosos. Por esta razón, solo las grandes organizaciones utilizan centros de datos privados creados para alojar sus datos y proporcionar servicios a los usuarios. Las organizaciones más pequeñas que no pueden mantener su propio centro de datos privado pueden reducir el costo total de propiedad mediante el arrendamiento de servicios de servidor y almacenamiento a una organización de centro de datos más grande en la nube.

13.2. Virtualización

13.2.1. Computación en la nube y virtualización

En el tema anterior, ha aprendido acerca de los servicios en la nube y los modelos en la nube. En este tema se explicará la virtualización. Los términos «computación en la nube» y «virtualización» suelen usarse de manera intercambiable; no obstante, significan dos cosas distintas. La virtualización es la base de la computación en la nube. Sin esta base, la computación en la nube que se implementa masivamente no sería posible.

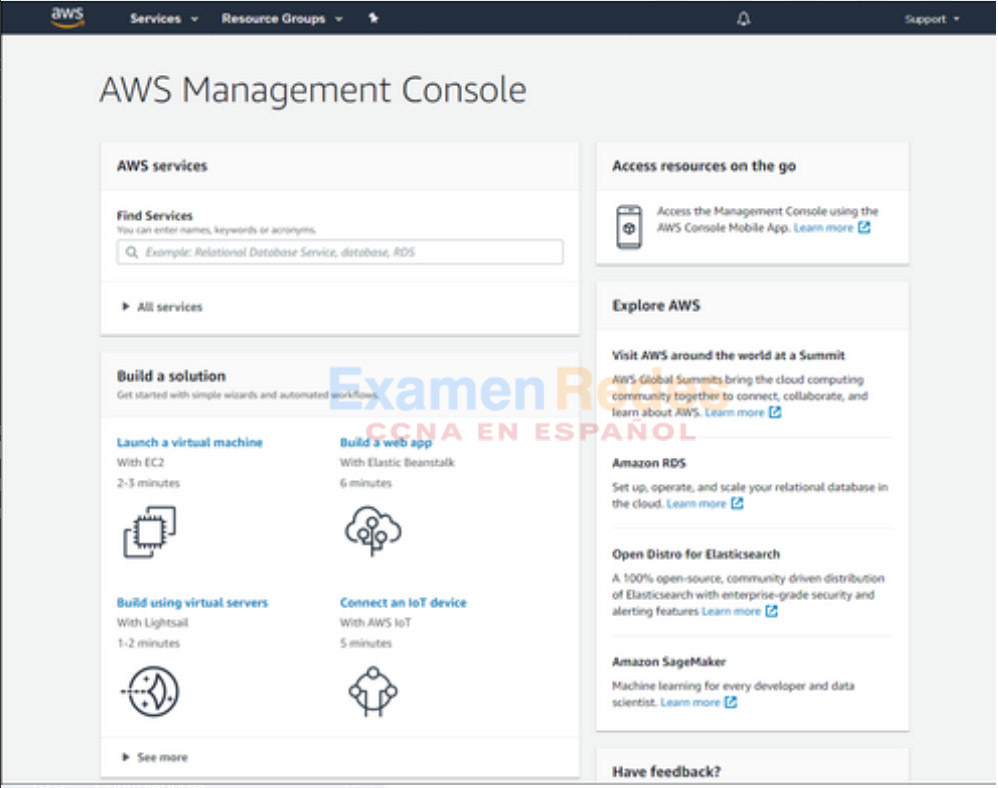

La virtualización separa el sistema operativo (SO) del hardware. Varios proveedores ofrecen servicios virtuales en la nube que permiten aprovisionar servidores de manera dinámica según sea necesario. Por ejemplo, Amazon Web Services (AWS) proporciona una forma sencilla para que los clientes aprovisionen dinámicamente los recursos informáticos que necesitan. Estas instancias virtualizadas de los servidores se crean a pedido. Como se muestra en la figura, el administrador de red puede implementar una variedad de servicios desde AWS Management Console, incluidas máquinas virtuales, aplicaciones web, servidores virtuales y conexiones a dispositivos IoT.

13.2.2. Servidores dedicados

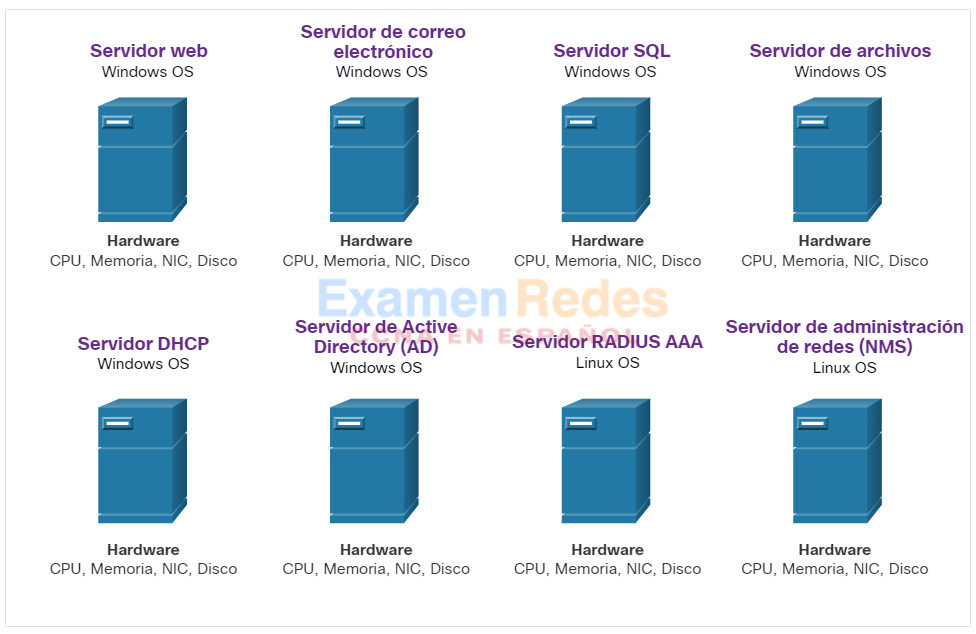

Para poder apreciar completamente la virtualización, primero es necesario entender un poco parte la historia de la tecnología de los servidores. Históricamente, los servidores empresariales consistían en un sistema operativo de servidor, como Windows Server o Linux Server, instalado en un hardware específico, como se muestra en la figura. Toda la RAM, la potencia de procesamiento y todo el espacio del disco duro de un servidor se dedicaban al servicio proporcionado (por ejemplo, red, servicios de correo electrónico, etc).

Dedicated Servers

El principal problema con esta configuración es que cuando falla un componente, el servicio proporcionado por este servidor no se encuentra disponible. Esto se conoce como punto único de falla. Otro problema era que los servidores dedicados eran infrautilizados. A menudo, los servidores dedicados estaban inactivos durante largos períodos de tiempo, esperando hasta que hubiera una necesidad de ofrecer un servicio específico que estos proporcionaban. Estos servidores malgastaban energía y ocupaban más espacio del que estaba garantizado por la cantidad de servicio. Esto se conoce como proliferación de servidores.

13.2.3. Virtualización de servidores

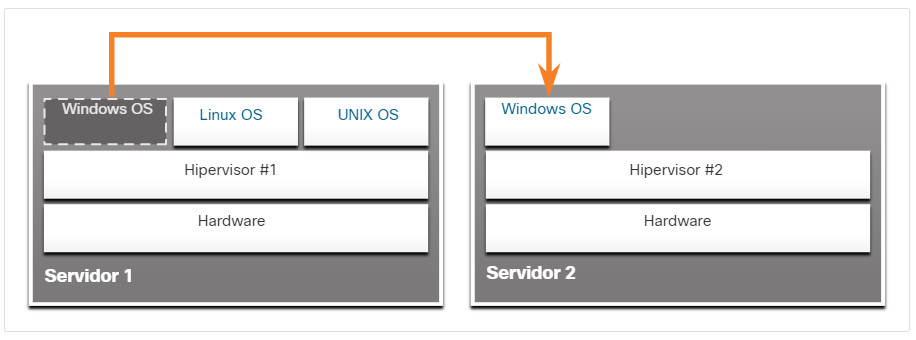

La virtualización de servidores saca provecho de los recursos inactivos y consolida el número de servidores requeridos. Esto también permite que múltiples sistemas operativos existan en una sola plataforma de hardware.

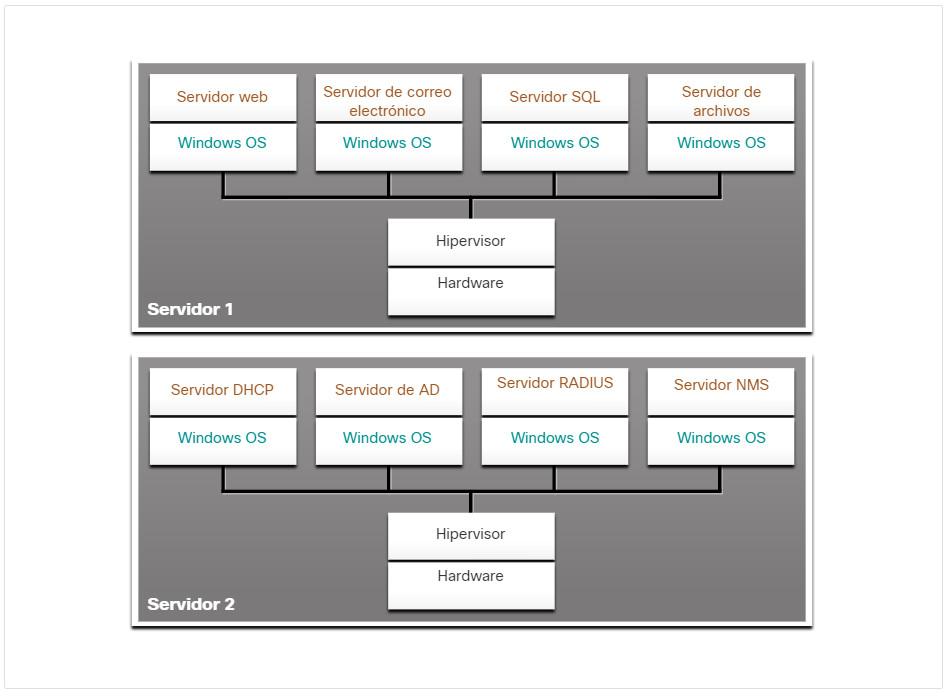

Por ejemplo, en la figura, los ocho servidores dedicados anteriores se consolidaron en dos servidores con hipervisores para admitir varias instancias virtuales de los sistemas operativos.

Hypervisor OS Installation

El uso de la virtualización normalmente incluye redundancia para brindar protección desde un punto único de falla. La redundancia se puede implementar de diferentes maneras. Si falla el hipervisor, se puede reiniciar la VM en otro hipervisor. Además, la misma VM se puede ejecutar en dos hipervisores simultáneamente copiando las instrucciones de RAM y de CPU entre estos. Si falla un hipervisor, la VM continúa ejecutándose en el otro supervisor. Los servicios que se ejecutan en las VM también son virtuales y se pueden instalar o deshabilitar dinámicamente, según sea necesario.

El Hypervisor es un programa, un firmware o un hardware que suma una capa de abstracción a la parte superior del hardware físico real. La capa de abstracción se utiliza para crear máquinas virtuales que tienen acceso a todo el hardware de la máquina física, como CPU, memoria, controladores de disco y NIC. Cada una de esas máquinas virtuales ejecuta un sistema operativo completo y separado. Con la virtualización, las empresas ahora pueden consolidar la cantidad de servidores necesarios. Por ejemplo, no resulta raro que 100 servidores físicos se consoliden como máquinas virtuales sobre 10 servidores físicos que usan hipervisores.

13.2.4. Ventajas de la virtualización

Una de las ventajas más importantes de la virtualización es un menor costo total:

- Menos cantidad de equipos necesarios: La virtualización permite la consolidación de servidores, lo que reduce la cantidad necesaria de servidores físicos, dispositivos de red e infraestructura de soporte. También significa menores costos de mantenimiento.

- Menor consumo de energía: La consolidación de servidores reduce los costos mensuales de alimentación y refrigeración. El consumo reducido ayuda a las empresas a alcanzar una huella de carbono más pequeña.

- Menos espacio necesario: La consolidación de servidores con virtualización reduce la huella total del centro de datos. Menos servidores, dispositivos de red y racks reducen la cantidad de espacio de piso requerido.

Estos son los beneficios adicionales de la virtualización:

- Simplificación de prototipos: Se pueden crear rápidamente laboratorios autónomos que operan en redes aisladas para las pruebas y los prototipos de instalaciones de red. Si se comete un error, un administrador puede volver simplemente a una versión anterior. Los entornos de prueba pueden estar en línea, pero deben estar aislados de los usuarios finales. Una vez terminadas las pruebas, los servidores y sistemas pueden implementarse para los usuarios finales.

- Aprovisionamiento más rápido de servidores: La creación de un servidor virtual es mucho más rápida que el aprovisionamiento de un servidor físico.

- Mayor tiempo de actividad de servidores: La mayoría de las plataformas de virtualización de servidores actuales ofrecen funciones avanzadas y redundantes de tolerancia a fallas, como migración en vivo, migración de almacenamiento, alta disponibilidad y planificación de recursos distribuidos.

- Recuperación tras un desastre mejorada: La virtualización ofrece soluciones avanzadas de continuidad de los negocios. Brinda la capacidad de abstracción de hardware de modo que el sitio de recuperación ya no necesite tener hardware que sea idéntico al hardware del entorno de producción. La mayoría de las plataformas de virtualización de servidores de la empresa también tienen software que puede ayudar a probar y automatizar las fallas antes de que suceda un desastre.

- Soporte de tecnologías heredadas: La virtualización puede ampliar la vida útil de los SO y las aplicaciones, para que las organizaciones tengan más tiempo para migrarse a soluciones más nuevas.

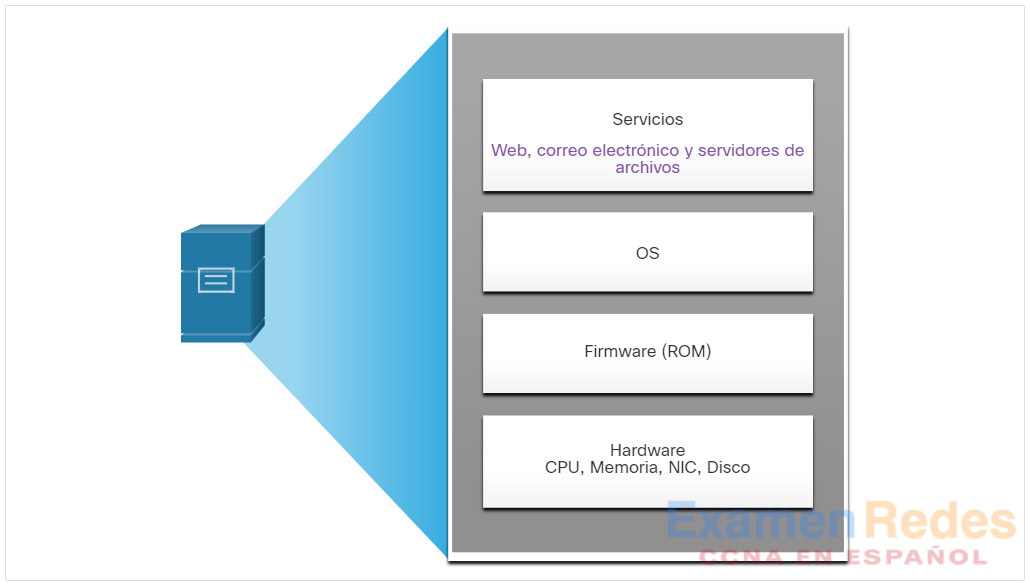

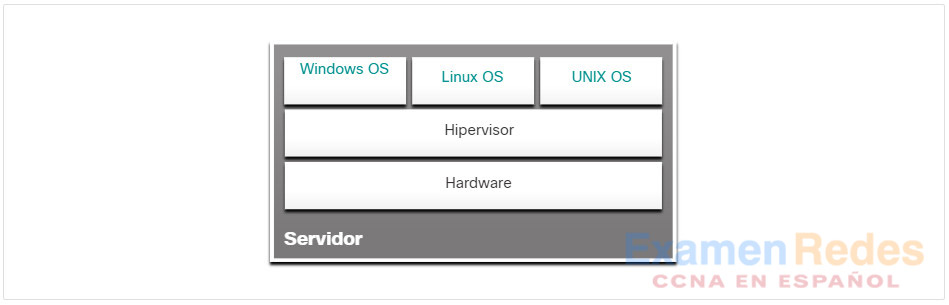

13.2.5. Capas de abstracción

Para ayudar a explicar cómo funciona la virtualización, es útil usar capas de abstracción en las arquitecturas informáticas. Un sistema de computación consta de las siguientes capas de abstracción, como se muestra en la figura:

- Servicios

- OS

- Firmware

- Hardware

En cada una de estas capas de abstracción, se utiliza algún tipo de código de programación como interfaz entre la capa inferior y la capa superior. Por ejemplo, el lenguaje de programación C suele usarse para programar el firmware que tiene acceso al hardware.

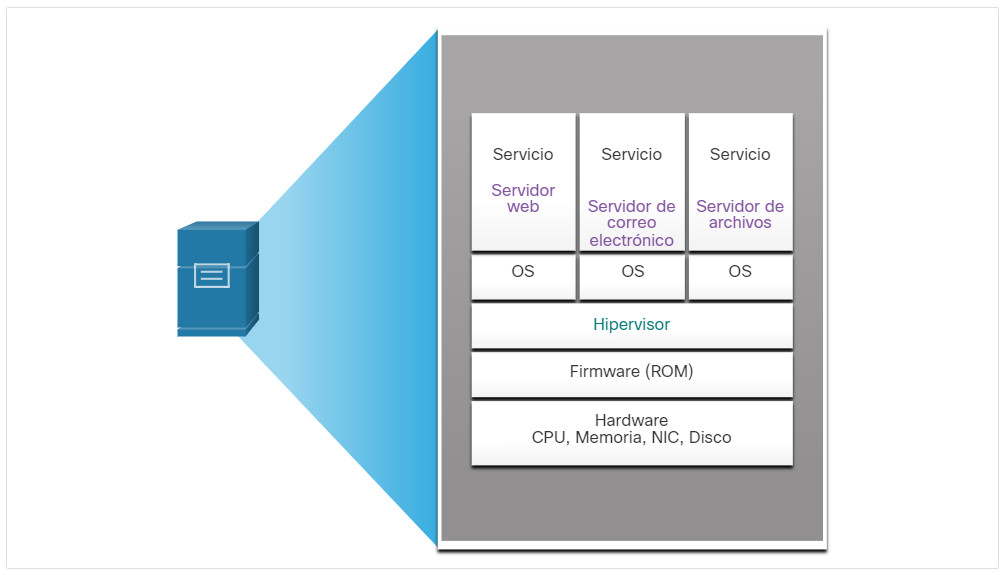

Un ejemplo de virtualización se muestra en la figura. Un hipervisor se instala entre el firmware y el OS. El hipervisor puede admitir varias instancias de SO.

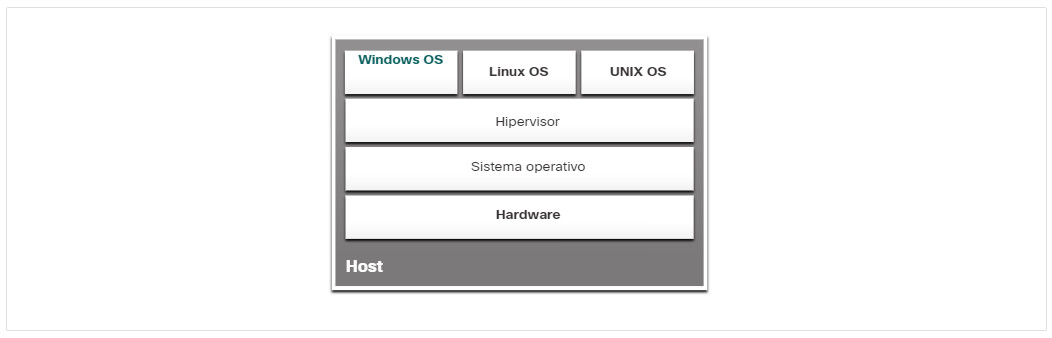

13.2.6. Hipervisores de tipo 2

Un hipervisor, tipo 2, es un software que crea y ejecuta instancias de VM. La computadora, en la que un hipervisor está ejecutando una o más VM, es un equipo host. Los hipervisores de tipo 2 también se denominan hipervisores alojados. Esto se debe a que el hipervisor está instalado sobre el OS existente, como Mac OS X, Windows o Linux. Luego, una o más instancias adicionales de OS se instalan sobre el hipervisor, como se muestra en la figura.

Una gran ventaja de los hipervisores de tipo 2 es que el software de la consola de administración no es necesario.

Los hipervisores de tipo 2 son muy populares entre los consumidores y en las organizaciones que experimentan con la virtualización. Los hipervisores comunes de tipo 2 incluyen:

- Virtual PC

- VMware Workstation

- Oracle VM VirtualBox

- VMware Fusion

- Mac OS X Parallels

Muchos de estos hipervisores de tipo 2 son gratuitos. Sin embargo, algunos hipervisores ofrecen funciones más avanzadas por una tarifa.

Note: Es importante asegurarse de que la máquina host sea lo suficientemente robusta para instalar y ejecutar las máquinas virtuales, de modo que no se quede sin recursos.

13.3. Infraestructura de red virtual

13.3.1. Hipervisores de tipo 1

En el tema anterior, aprendió sobre la virtualización. Este tema abarcará la infraestructura de red virtual.

El hypervisor de tipo 1 también se denomina infraestructura física (bare metal), porque el hypervisor está instalado directamente en el hardware. Los hipervisores de tipo 1 se usan generalmente en los servidores empresariales y los dispositivos de redes para centros de datos.

Con los hipervisores de tipo 1, el hipervisor se instala directamente en el servidor o en el hardware de red. Luego, las instancias de OS se instalan sobre el hipervisor, como se muestra en la figura. Los hipervisores de tipo 1 tienen acceso directo a los recursos de hardware. Por lo tanto, son más eficientes que las arquitecturas alojadas. Los hipervisores de tipo 1 mejoran la escalabilidad, el rendimiento y la solidez.

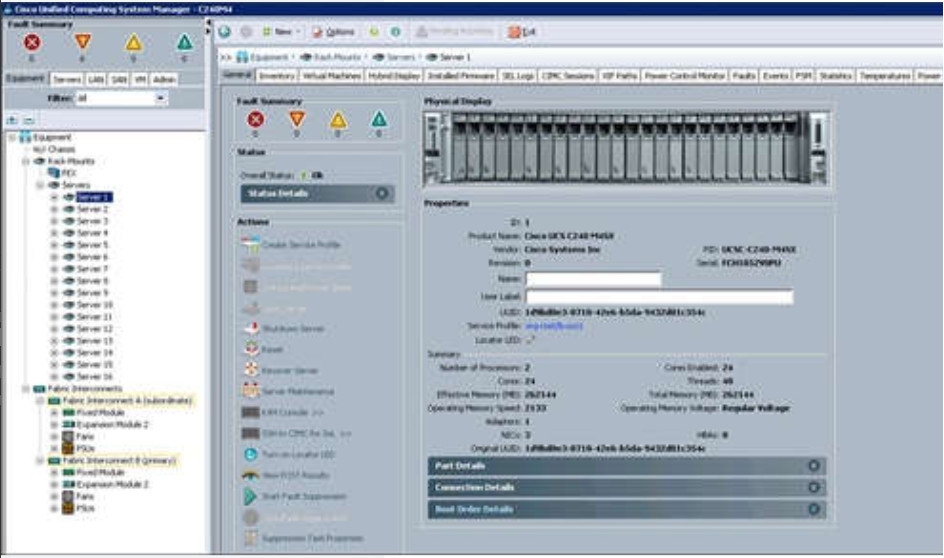

13.3.2. Instalación de una VM en un hipervisor

Cuando se instala un hipervisor de tipo 1 y se reinicia el servidor, sólo se muestra la información básica, como la versión de OS, la cantidad de RAM y la dirección IP. Una instancia de OS no se puede crear a partir de esta pantalla. Los hipervisores de tipo 1 requieren una “consola de administración” para administrar el hipervisor. El software de administración se utiliza para administrar varios servidores con el mismo hipervisor. La consola de administración puede consolidar los servidores automáticamente y encender o apagar los servidores, según sea necesario.

Por ejemplo, supongamos que el Servidor 1 de la figura se está quedando sin recursos. Para hacer que haya más recursos disponibles, la consola de administración mueve la instancia de Windows al hipervisor en el Servidor2. La consola de administración también se puede programar con umbrales que activarán el movimiento automáticamente.

La consola de administración proporciona la recuperación ante las fallas de hardware. Si falla un componente del servidor, la consola de administración mueve la VM a otro servidor. La consola de administración de Cisco Unified Computing System (UCS) se muestra en la figura. Cisco UCS Manager controla varios servidores y administra los recursos de miles de VM.

Algunas consolas de administración también permiten la sobre-asignación. La sobre-asignación se produce cuando se instalan varias instancias de OS, pero su asignación de memoria excede la cantidad total de memoria que tiene un servidor. Por ejemplo, un servidor tiene 16 GB de RAM, pero el administrador crea cuatro instancias de OS con 10 GB de RAM asignadas a cada una. Este tipo de asignación excesiva es habitual porque las cuatro instancias de OS requieren raramente los 10 GB completo de RAM en todo momento.

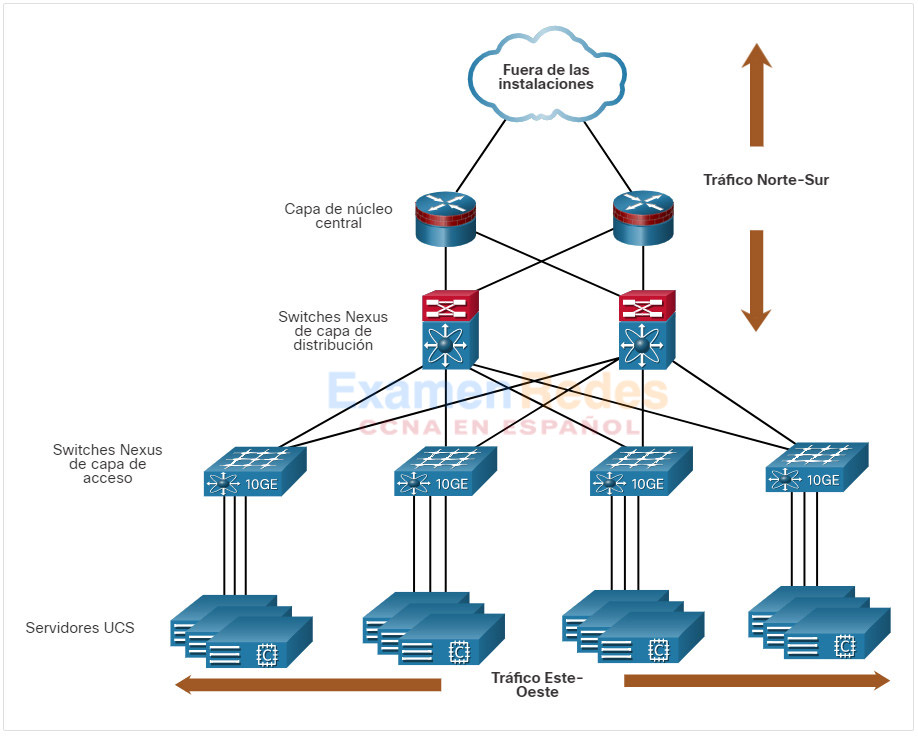

13.3.3. La complejidad de la virtualización de redes

La virtualización del servidor oculta los recursos del servidor, como el número e identidad de servidores físicos, procesadores y sistemas operativos de los usuarios del servidor. Esta práctica puede crear problemas si el centro de datos está utilizando las arquitecturas de red tradicionales.

Por ejemplo, las LAN virtuales (VLAN) utilizadas por las VM se deben asignar al mismo puerto de switch que el servidor físico que ejecuta el hipervisor. Sin embargo, las VM son trasladables, y el administrador de la red debe poder agregar, descartar y cambiar los recursos y los de la red. Este proceso sería manual y llevaría mucho tiempo con los switches de red tradicionales.

Otro problema es que los flujos de tráfico difieren considerablemente del modelo cliente-servidor tradicional. Normalmente, un centro de datos intercambia una cantidad considerable de tráfico entre servidores virtuales, como los servidores UCS que se muestran en la figura. Estos flujos se denominan tráfico Este-Oeste y pueden cambiar en ubicación e intensidad con el tiempo. El tráfico Norte-Sur se produce entre las capas de distribución y núcleo y suele ser tráfico destinado a ubicaciones fuera del sitio, como otro centro de datos, otros proveedores de nube o Internet.

El tráfico dinámico en constante cambio requiere un enfoque flexible para la administración de recursos de red. Las infraestructuras de red existentes pueden responder a los requisitos cambiantes, relacionados con la administración de los flujos de tráfico utilizando las configuraciones de calidad de servicio (QoS) y de ajustes de nivel de seguridad para los flujos individuales. Sin embargo, en empresas grandes que utilizan equipos de varios proveedores, cada vez que se activa una nueva VM, la reconfiguración necesaria puede llevar mucho tiempo.

La infraestructura de red también puede beneficiarse de la virtualización. Las funciones de red se pueden virtualizar. Cada dispositivo de red se puede segmentar en varios dispositivos virtuales que funcionan como dispositivos independientes. Entre los ejemplos se incluyen subinterfaces, interfaces virtuales, VLAN y tablas de enrutamiento. El enrutamiento virtualizado se denomina enrutamiento y reenvío virtuales (VRF).

¿Cómo se virtualiza la red? La respuesta se encuentra en cómo funciona un dispositivo de red utilizando un plano de datos y un plano de control, como se discute en el siguiente tema.

13.4. Redes definidas por software

13.4.1. Video – Redes definidas por software

Haga clic en Reproducir para ver un video sobre programación de red, redes definidas por software (SDN) y controladores.

13.4.2. Plano de control y plano de datos

En el tema anterior se explicaba la infraestructura de red virtual. Este tema abarcará las redes definidas por software (SDN). SDN fue explicado en el video anterior. Vamos a cubrir más detalles aquí.

Un dispositivo de red contiene los siguientes planos:

- Plano de control – Suele considerarse el cerebro del dispositivo. Se utiliza para tomar decisiones de reenvío. El plano de control contiene los mecanismos de reenvío de ruta de capa 2 y capa 3, como las tablas de vecinos de protocolo de enrutamiento y las tablas de topología, las tablas de enrutamiento IPv4 e IPv6, STP, y la tabla ARP. La información que se envía al plano de control es procesada por la CPU.

- Plano de datos – También conocido como plano de reenvío, este plano suele ser la estructura de switch que conecta lo varios puertos de red de un dispositivo. El plano de datos de cada dispositivo se utiliza para reenviar los flujos de tráfico. Los routers y los switches utilizan la información del plano de control para reenviar el tráfico entrante desde la interfaz de egreso correspondiente. La información en el plano de datos generalmente es procesada por un procesador especial del plano de datos sin que la CPU se involucre.

Haga clic en cada botón para obtener una ilustración y una explicación de la diferencia entre el funcionamiento del control localizado en un switch de capa 3 y un controlador centralizado en SDN

- Switch de capa 3 y CEF

- SDN y controlador central

CEF es una tecnología de switching de IP de capa 3 que permite que el reenvío de los paquetes ocurra en el plano de datos sin que se consulte el plano de control. En CEF, la tabla de routing del plano de control rellena previamente la tabla de base de información de reenvío (FIB) de CEF en el plano de datos. La tabla de ARP del plano de control se completa con la tabla de adyacencia. Luego el plano de datos reenvía directamente los paquetes en función de la información del FIB y la tabla de adyacencia, sin necesidad de consultar la información del plano de control.

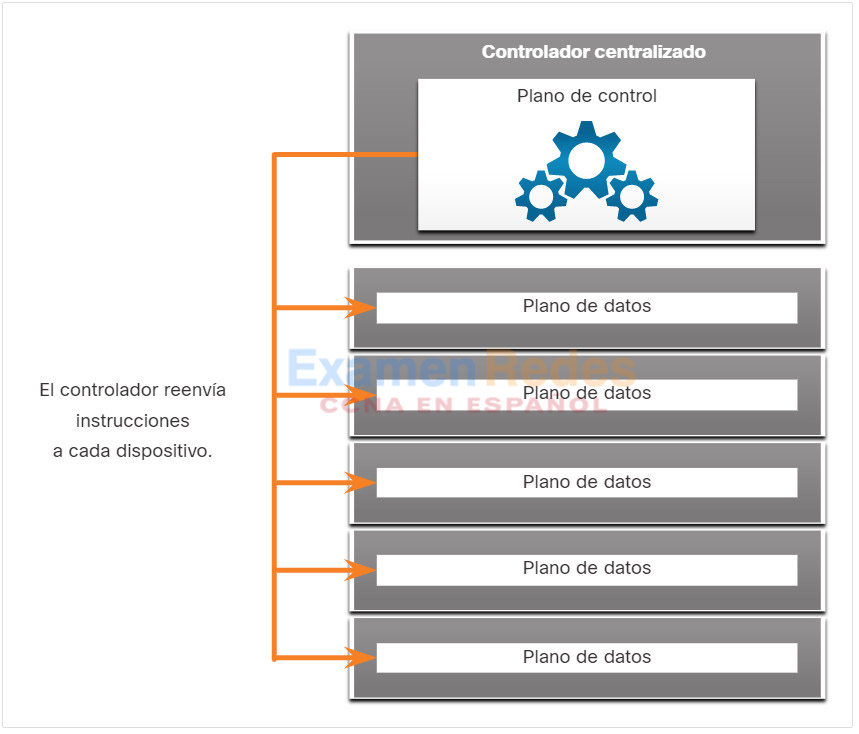

Centralized Control Plane

Plano de gestión

No se muestra en las figuras el plano de gestión, que es responsable de administrar un dispositivo a través de su conexión a la red. Los administradores de red utilizan aplicaciones como Secure Shell (SSH), Trivial File Transfer Protocol (TFTP), Secure FTP y Secure Hypertext Transfer Protocol (HTTPS) para acceder al plano de administración y configurar un dispositivo. El plano de administración es la forma en que ha accedido y configurado los dispositivos en sus estudios de redes. Además, protocolos como Simple Network Management Protocol (SNMP), utilizan el plano de administración.

13.4.3. Tecnologías de virtualización de red

Hace más de una década, VMware desarrolló una tecnología de virtualización que permitió que un sistema operativo host admitiera uno o más sistemas operativos cliente. La mayoría de las tecnologías de virtualización ahora se basan en esta tecnología. La transformación de los servidores exclusivos para los servidores virtualizados se ha adoptado y se implementa rápidamente en el centro de datos y las redes empresariales.

Se han desarrollado dos arquitecturas de red principales para admitir la virtualización de la red:

- Redes definidas por software (SDN) : una arquitectura de red que virtualiza la red, ofreciendo un nuevo enfoque para la administración y administración de redes que busca simplificar y optimizar el proceso de administración.

- Infraestructura centrada en aplicaciones (ACI) de Cisco – Solución de hardware diseñada específicamente para integrar la computación en la nube con la administración de centros de datos.

Los componentes de SDN pueden incluir los siguientes:

- OpenFlow – Este enfoque se desarrolló en la Universidad de Stanford para administrar el tráfico entre routers, switches, puntos de acceso inalámbrico y un controlador. El protocolo OpenFlow es un elemento básico en el desarrollo de soluciones de SDN. Busque OpenFlow y Open Networking Foundation para obtener más información.

- OpenStack – Este enfoque es una plataforma de virtualización y orquestación diseñada para crear entornos de nube escalables y proporcionar una solución IaaS. OpenStack se usa frecuentemente en conjunto con Cisco ACI. La organización en la red es el proceso para automatizar el aprovisionamiento de los componentes de red como servidores, almacenamiento, switches, routers y aplicaciones. Busque OpenStack para obtener más información.

- Otros componentes – Otros componentes incluyen la interfaz al sistema de routing (I2RS), la interconexión transparente de muchos enlaces (TRILL), Cisco FabricPath (FP) y los puentes de ruta más corta (SPB) de IEEE

13.4.4. Arquitecturas tradicionales y de SDN

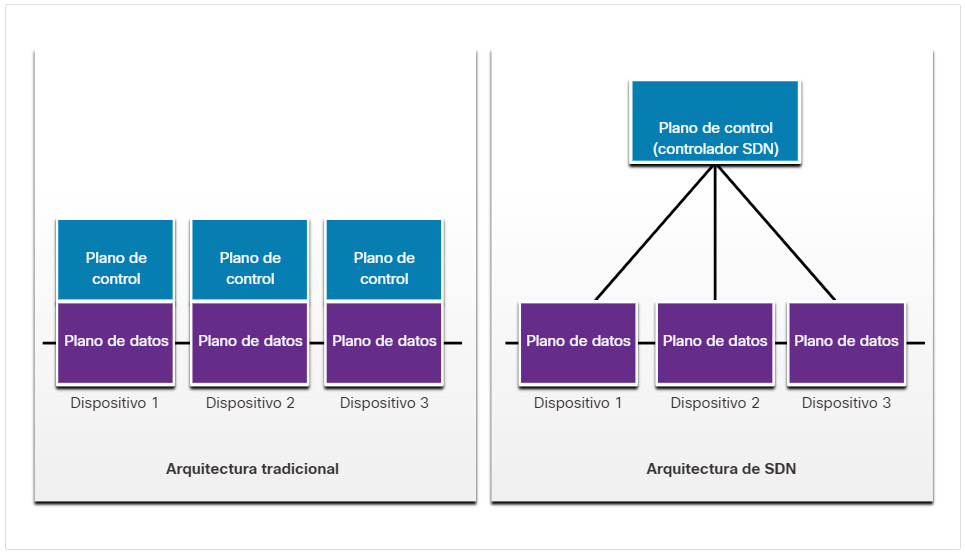

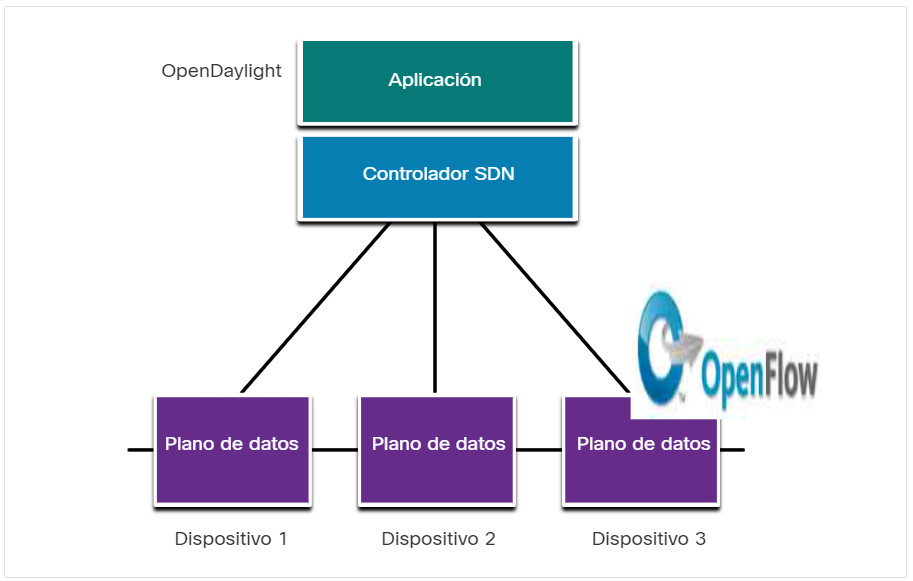

En un router o una arquitectura de switches tradicionales, el plano de control y las funciones del plano de datos se producen en el mismo dispositivo. Las decisiones de enrutamiento y el envío de paquetes son responsabilidad del sistema operativo del dispositivo. En SDN, la administración del plano de control se mueve a un controlador SDN centralizado. La figura compara la arquitectura tradicional contra SDN.

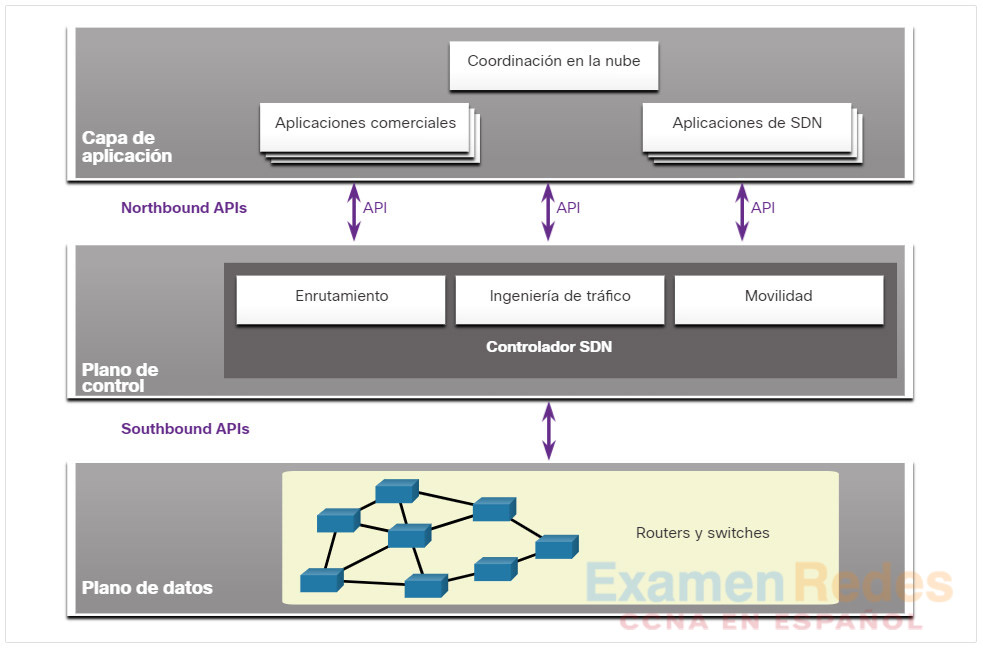

El controlador de SDN es una entidad lógica que permite que los administradores de red administren y determinen cómo el plano de datos de switches y routers debe administrar el tráfico de red. Coordina, media y facilita la comunicación entre las aplicaciones y los elementos de red.

El marco SDN completo se muestra en la figura. Observe el uso de interfaces de programación de aplicaciones (API) dentro del marco de SDN. Una API es un conjunto de solicitudes estandarizadas que definen la forma adecuada para que una aplicación solicite servicios de otra aplicación. El controlador de SDN usa los API ascendentes para comunicarse con las aplicaciones ascendentes. Estos administradores de red de ayuda de API forman el tráfico e implementan los servicios. El controlador SDN también utiliza API hacia el sur para definir el comportamiento de los planos de datos en switches y routers posteriores. OpenFlow es la API original descendente ampliamente implementada.

13.5. Controladores

13.5.1. Operaciones y controlador SDN

El tema anterior cubrió SDN. En este tema se explicarán los controladores.

El controlador SDN define los flujos de datos entre el plano de control centralizado y los planos de datos en routers y switches individuales.

Cada flujo que viaja por la red debe primero obtener permiso del controlador SDN, que verifica que la comunicación esté permitida según la política de red. Si el controlador permite un flujo, calcula una ruta para que tome el flujo y agrega una entrada para ese flujo en cada uno de los switches que están a lo largo de la ruta.

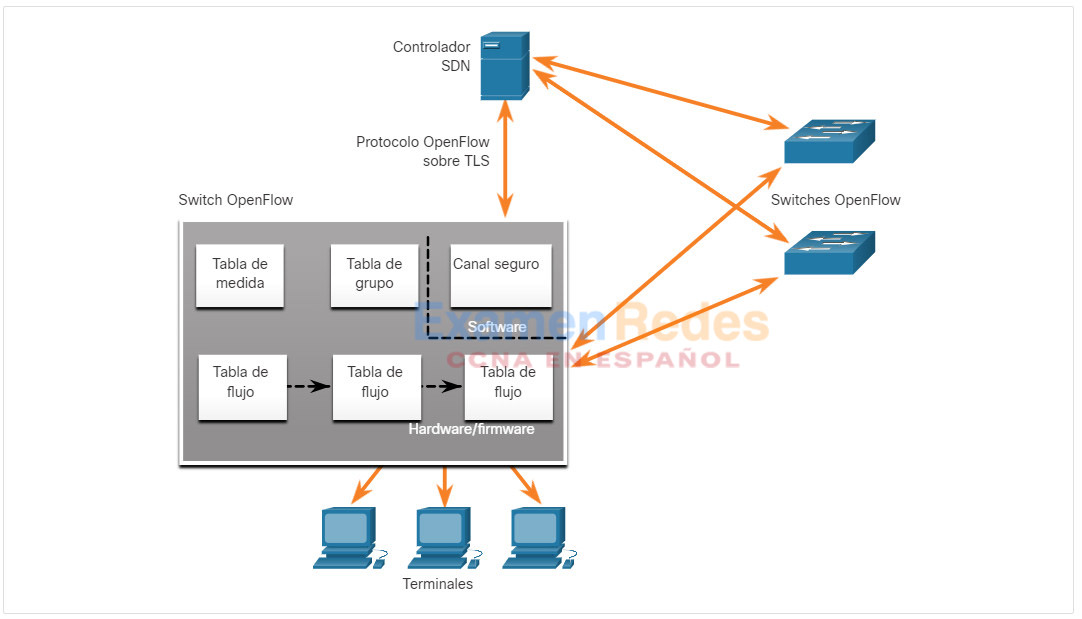

El controlador realiza todas las funciones complejas. El controlador completa las tablas de flujo. Los switches administran las tablas de flujo. En la figura, un controlador SDN se comunica con los switches compatibles con OpenFlow con el protocolo OpenFlow. Este protocolo utiliza Transport Layer Security (TLS) para enviar de manera segura las comunicaciones del plano de control a través de la red. Cada switch de OpenFlow se conecta con otros switches de OpenFlow. También pueden conectarse a los dispositivos de usuarios finales que forman parte de un flujo de paquetes.

Dentro de cada switch, se utiliza una serie de tablas implementadas en el hardware o el firmware para administrar flujos de paquetes a través del switch. Para el switch, un flujo es una secuencia de paquetes que coincide con una entrada específica en una tabla de flujo.

Los tres tipos de tablas que se muestran en la figura anterior son los siguientes:

- Tabla de flujo – Esta tabla asigna los paquetes entrantes a un flujo determinado y especifica las funciones que deben realizarse en los paquetes. Puede haber tablas de flujo múltiples que funcionan a modo de canalización.

- Tabla de grupos – Una tabla de flujo puede dirigir un flujo a una tabla de grupos, que puede alimentar una variedad de acciones que afecten a uno o más flujos

- Tabla de medidor – Esta tabla activa una variedad de acciones relacionadas con el funcionamiento en un flujo

13.5.2. Vídeo – Cisco ACI

Muy pocas organizaciones tienen realmente el deseo o las habilidades para programar la red utilizando las herramientas de SDN. Sin embargo, la mayoría de las organizaciones desea automatizar la red, acelerar la implementación de aplicaciones y alinear sus infraestructuras de TI para cumplir mejor con los requisitos empresariales. Cisco desarrolló la Infraestructura centrada en aplicaciones (ACI) para alcanzar los siguientes objetivos de maneras más avanzadas y más innovadoras que antes los enfoques de SDN.

Cisco ACI es una solución de hardware diseñada específicamente para integrar la computación en la nube con la administración de centros de datos. En un nivel alto, el elemento de políticas de la red se elimina del plano de datos. Esto simplifica el modo en que se crean redes del centro de datos.

Haga clic en Reproducir para ver un vídeo sobre la evolución de SDN y ACI.

13.5.3. Componentes principales de ACI

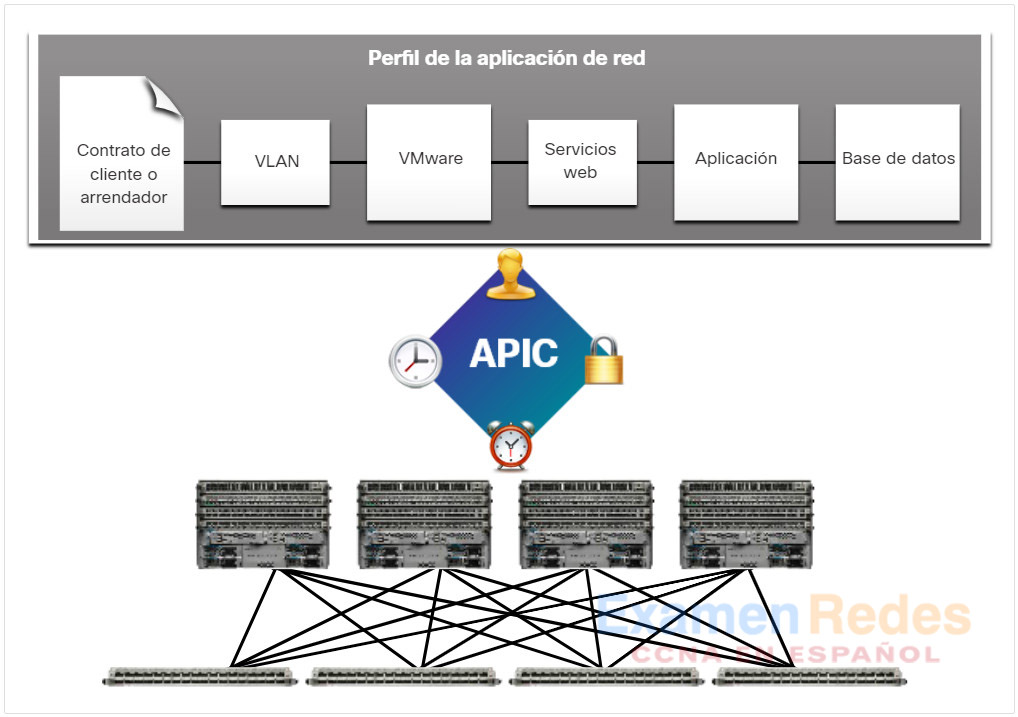

Estos son los tres componentes principales de la arquitectura de ACI:

- Perfil de aplicación de red (ANP) – Un ANP es una colección de grupos de terminales (EPG) con sus conexiones y las políticas que definen dichas conexiones. Los EPG que se muestran en la figura, como VLAN, servicios web y aplicaciones, son solo ejemplos. Un ANP es con frecuencia mucho más complejo.

- Controlador de infraestructura de política de aplicación (APIC) – El APIC se considera el cerebro de la arquitectura de ACI. El APIC es un controlador centralizado de software que administra y opera una estructura agrupada ACI escalable. Está diseñado para la programabilidad y la administración centralizada. Traduce las políticas de las aplicaciones a la programación de la red.

- Switches de la serie 9000 de Cisco Nexus – Estos switches proporcionan una estructura de switching con reconocimiento de aplicaciones y operan con un APIC para administrar la infraestructura virtual y física de la red.

El APIC se coloca entre el APN y la infraestructura de red habilitada para ACI. El APIC traduce los requisitos de la aplicación en una configuración de red para satisfacer esas necesidades, como se muestra en la figura

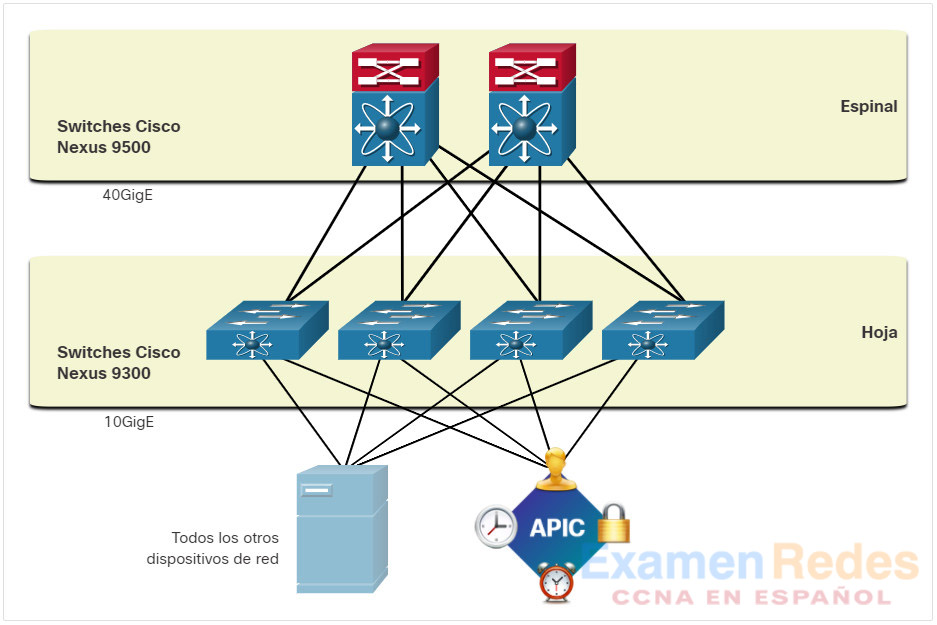

13.5.4. Topología de Hoja-espina

La estructura Cisco ACI está compuesto por los switches APIC y Cisco Nexus de la serie 9000 que utilizan una topología de hoja espinal de dos niveles, como se muestra en la figura. Los switches de hoja siempre se unen a las espinas, pero nunca se unen entre sí. Del mismo modo, los switches de la columna solo se conectan a los switches de hoja y núcleo (no se muestran). En esta topología de dos niveles, todo está a un salto de todo lo demás.

Los APIC de Cisco y todos los demás dispositivos de la red se conectan físicamente a los switches de hoja.

En comparación con una SDN, el controlador de APIC no manipula la ruta de datos directamente. En cambio, el APIC centraliza la definición de la política y programa los switches de hoja para reenviar el tráfico en función de las políticas definidas.

13.5.5. Tipos de SDN

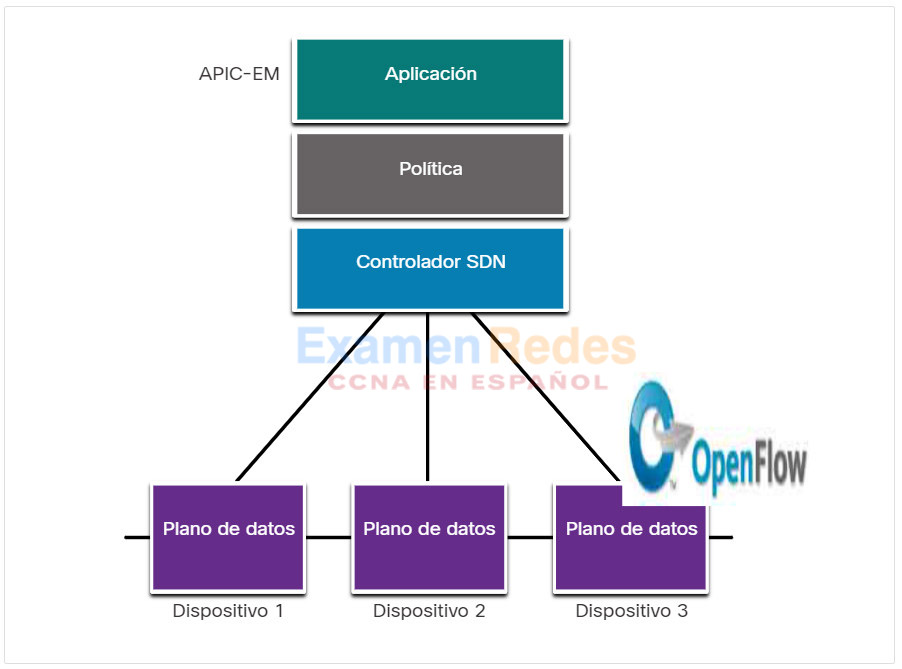

El Módulo empresarial del Controlador de infraestructura de política de aplicación (APIC-EM) de Cisco amplía las capacidades de ACI para las instalaciones empresariales y de campus. Para comprender mejor el APIC-EM, es útil dar una mirada más amplia a los tres tipos de SDN.

Haga clic en cada tipo para obtener más información.

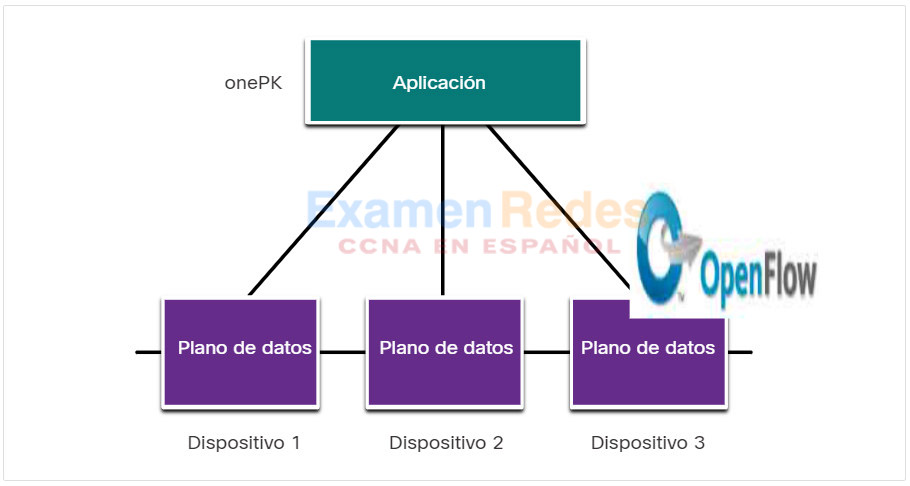

- SDN basada en dispositivos

- SDN basada en controladores

- SDN basada en políticas

En este tipo de SDN, los dispositivos son programables por las aplicaciones que se ejecutan en el mismo dispositivo o en un servidor en la red, como se muestra en la figura. Cisco OnePK es un ejemplo de un SDN basado en dispositivos. Permite que los programadores creen aplicaciones utilizando C y a Java con Python para integrar e interactuar con los dispositivos Cisco.

Este tipo de SDN utiliza un controlador centralizado que tiene conocimiento de todos los dispositivos de la red, como se muestra en la figura. Las aplicaciones pueden interactuar con el controlador responsable de administrar los dispositivos y de manipular los flujos de tráfico en la red. El controlador SDN Cisco Open es una distribución comercial de Open Daylight.

Este tipo de SDN es similar a un SDN basado en controladores donde un controlador centralizado tiene una vista de todos los dispositivos de la red, como se muestra en la figura. El SDN basado en políticas incluye una capa de políticas adicional que funciona a un nivel de abstracción mayor. Usa aplicaciones incorporadas que automatizan las tareas de configuración avanzadas mediante un flujo de trabajo guiado y una GUI fácil de usar. No se necesitan conocimientos de programación. Cisco APIC-EM es un ejemplo de este tipo de SDN.

13.5.6. Características APIC-EM

Cada tipo de SDN tiene sus propias características y ventajas. Las SDN basadas en políticas son las más resistentes, lo que proporciona un mecanismo simple para controlar y administrar políticas en toda la red.

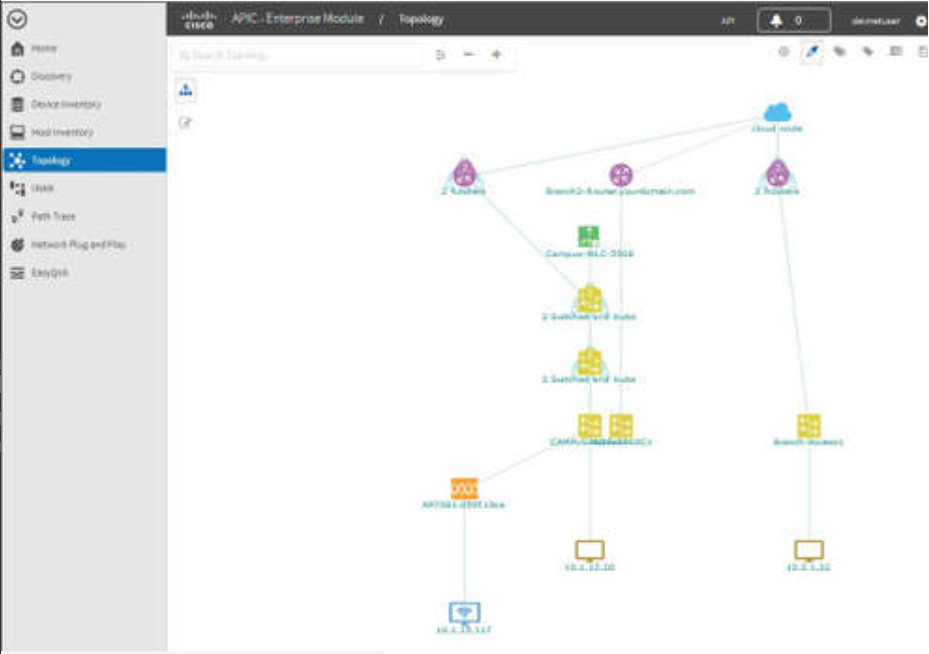

Cisco APIC-EM es un ejemplo de SDN basado en políticas. Cisco APIC-EM proporciona una interfaz única para la administración de red que incluye:

- descubrir y acceder a los inventarios de dispositivos y hostes,

- ver la topología (como se muestra en la figura),

- trazar una ruta entre los puntos finales, y

- establecer políticas.

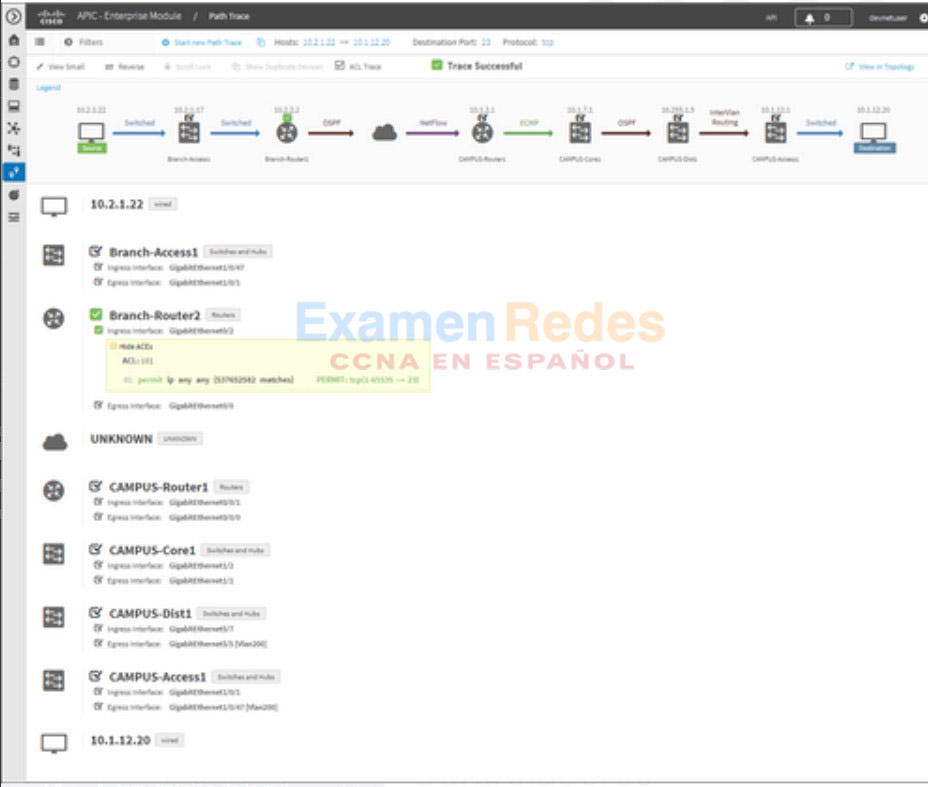

13.5.7. Trazado de ruta APIC-EM

La herramienta APIC-EM Path Trace permite al administrador visualizar fácilmente los flujos de tráfico y descubrir cualquier entrada ACL en conflicto, duplicada o sombreada. Esta herramienta examina las ACL específicas en la ruta entre dos nodos finales y muestra todos los problemas potenciales. Puede ver dónde las ACL a lo largo de la ruta permitieron o denegaron el tráfico, como se muestra en la figura. Observe cómo Branch-Router2 es permitir todo el tráfico. El administrador de red ahora puede realizar ajustes, si es necesario, para filtrar mejor el tráfico.

13.6. Módulo de Práctica y Prueba

13.6.1. Práctica de laboratorio: Instalación de Linux en una máquina virtual y exploración de la GUI

En esta práctica de laboratorio, instalará el OS Linux en una máquina virtual utilizando una aplicación de virtualización de escritorio, como VirtualBox. Después de completar la instalación, explorará la interfaz de la GUI.

13.6.2. ¿Qué aprendió en este módulo?

Computación en la nube

La computación en la nube implica una gran cantidad de computadoras conectadas a través de una red que puede estar ubicada físicamente cualquier lugar. La computación en la nube puede reducir costos operativos al utilizar los recursos con mayor eficacia. La computación en la nube aborda una variedad de problemas de administración de datos:

- Permite el acceso a los datos organizacionales en cualquier momento y lugar.

- Perfecciona las operaciones de TI de la organización mediante la suscripción a solo los servicios necesarios.

- Elimina o reduce la necesidad de equipamiento, mantenimiento y administración de TI en el sitio.

- Reduce los costos de los equipos, la electricidad, los requisitos de planta físicos y las necesidades de capacitación del personal.

- Permite respuestas rápidas a los requisitos de volumen de datos crecientes.

Los tres principales servicios de Computación en la nube definidos por el National Institute of Standards and Technology (NIST) son Software as a Service (SaaS), Platform as a Service (PaaS) e Infrastructure as a Service (IaaS). Con SaaS, el proveedor de la nube es responsable del acceso a las aplicaciones y servicios, como el correo electrónico, la comunicación y Office 365 que se entregan a través de Internet. Con PaaS, el proveedor de la nube es responsable de proporcionar a los usuarios acceso a las herramientas y servicios de desarrollo utilizados para entregar las aplicaciones. Con IaaS, el proveedor de la nube es responsable de dar acceso a los administradores de TI al equipo de red, los servicios de red virtualizados y la infraestructura de red de soporte. Los cuatro tipos de nubes son públicas, privadas, híbridas y comunitarias. Las aplicaciones y los servicios basados en la nube que se ofrecen en una nube pública están a disposición de la población en general. Las aplicaciones y los servicios basados en la nube que se ofrecen en una nube privada están destinados a una organización o una entidad específica, como el gobierno. Una nube híbrida está compuesta por dos o más nubes (ejemplo: parte privada, parte pública), donde cada parte permanece como un objeto separado, pero ambas están conectadas usando una sola arquitectura. Se crea una nube comunitaria para uso exclusivo de una comunidad específica.

Virtualización

Los términos «computación en la nube» y «virtualización» suelen usarse de manera intercambiable; no obstante, significan dos cosas distintas. La virtualización es la base de la computación en la nube. La virtualización separa el sistema operativo (SO) del hardware. Históricamente, los servidores empresariales consistían en un sistema operativo de servidor, como Windows Server o Linux Server, instalado en hardware específico. Toda la RAM, la potencia de procesamiento y el espacio en el disco duro de un servidor se dedicaron al servicio. Cuando un componente falla, el servicio que proporciona este servidor deja de estar disponible. Esto se conoce como punto único de falla. Otro problema con los servidores dedicados es que a menudo permanecen inactivos durante largos períodos de tiempo, esperando hasta que sea necesario brindar el servicio específico que brindan. Esto desperdicia energía y recursos (expansión de servidores). La virtualización reduce los costos porque se requiere menos equipo, se consume menos energía y se requiere menos espacio. Proporciona prototipos más fáciles, aprovisionamiento de servidores más rápido, mayor tiempo de actividad del servidor, recuperación ante desastres mejorada y soporte heredado. Un sistema informático consta de las siguientes capas de abstracción: servicios, sistema operativo, firmware y hardware. Con los hipervisores de tipo 1, el hipervisor se instala directamente en el servidor o en el hardware de red. Un hipervisor, tipo 2, es un software que crea y ejecuta instancias de VM. Se puede instalar en la parte superior del sistema operativo o se puede instalar entre el firmware y el sistema operativo. Un hipervisor, tipo 2, es un software que crea y ejecuta instancias de VM.

Infraestructura de red virtual

El hypervisor de tipo 1 también se denomina infraestructura física (bare metal), porque el hypervisor está instalado directamente en el hardware. Los hipervisores tipo 1 tienen acceso directo a los recursos de hardware y son más eficientes que las arquitecturas alojadas. Permiten mejorar la escalabilidad, el rendimiento y la solidez. Los hipervisores de tipo 1 requieren una “consola de administración” para administrar el hipervisor. El software de administración se utiliza para administrar varios servidores con el mismo hipervisor. La consola de administración puede consolidar los servidores automáticamente y encender o apagar los servidores, según sea necesario. La consola de administración proporciona la recuperación ante las fallas de hardware. Algunas consolas de administración también permiten la sobre-asignación. La virtualización del servidor oculta los recursos del servidor, como el número e identidad de servidores físicos, procesadores y sistemas operativos de los usuarios del servidor. Esta práctica puede crear problemas si el centro de datos está utilizando las arquitecturas de red tradicionales. Otro problema es que los flujos de tráfico difieren considerablemente del modelo cliente-servidor tradicional. Por lo general, un centro de datos intercambia una cantidad considerable de tráfico entre servidores virtuales. Estos flujos se denominan tráfico Este-Oeste y pueden cambiar en ubicación e intensidad con el tiempo. El tráfico Norte-Sur se produce entre las capas de distribución y núcleo y suele ser tráfico destinado a ubicaciones fuera del sitio, como otro centro de datos, otros proveedores de nube o Internet.

Redes definidas por software

Se han desarrollado dos arquitecturas de red principales para admitir la virtualización de red: Redes definidas por software (SDN) y Infraestructura centrada en aplicaciones de Cisco (ACI). SDN es un enfoque de redes donde la red es programable por software de forma remota. Los componentes de SDN pueden incluir OpenFlow, OpenStack y otros componentes. El controlador de SDN es una entidad lógica que permite que los administradores de red administren y determinen cómo el plano de datos de switches y routers debe administrar el tráfico de red. Un dispositivo de red contiene un plano de control y un plano de datos. El plano de control se considera el cerebro del dispositivo. Se utiliza para tomar decisiones de reenvío. El plano de control contiene los mecanismos de reenvío de ruta de capa 2 y capa 3, como las tablas de vecinos de protocolo de enrutamiento y las tablas de topología, las tablas de enrutamiento IPv4 e IPv6, STP, y la tabla ARP. La información que se envía al plano de control es procesada por la CPU. El plano de datos, también llamado plano de reenvío, es típicamente la estructura del switch que conecta los diversos puertos de red en un dispositivo. El plano de datos de cada dispositivo se utiliza para reenviar los flujos de tráfico. Los routers y los switches utilizan la información del plano de control para reenviar el tráfico entrante desde la interfaz de egreso correspondiente. La información en el plano de datos generalmente es procesada por un procesador especial del plano de datos sin que la CPU se involucre. Cisco Express Forwarding (CEF) utiliza el plano de control y el plano de datos para procesar paquetes. CEF es una tecnología de switching de IP de capa 3 que permite que el reenvío de los paquetes ocurra en el plano de datos sin que se consulte el plano de control. SDN es básicamente la separación del plano de control y el plano de datos. La función del plano de control es eliminada de cada dispositivo, y la misma es realizada desde un controlador central. El controlador centralizado comunica las funciones del plano de control a cada dispositivo. El plano de administración es responsable de administrar un dispositivo a través de su conexión a la red. Los administradores de red utilizan aplicaciones como Secure Shell (SSH), Trivial File Transfer Protocol (TFTP), Secure FTP y Secure Hypertext Transfer Protocol (HTTPS) para acceder al plano de administración y configurar un dispositivo. Los protocolos como Simple Network Management Protocol (SNMP) utilizan el plano de administración.

Controladores

El controlador de SDN es una entidad lógica que permite que los administradores de red administren y determinen cómo el plano de datos de switches y routers debe administrar el tráfico de red. El controlador SDN define los flujos de datos entre el plano de control centralizado y los planos de datos en routers y switches individuales. Cada flujo que viaja por la red debe primero obtener permiso del controlador SDN, que verifica que la comunicación esté permitida según la política de red. Si el controlador permite un flujo, calcula una ruta para que tome el flujo y agrega una entrada para ese flujo en cada uno de los switches que están a lo largo de la ruta. El controlador completa las tablas de flujo. Los switches administran las tablas de flujo. La tabla de flujo identifica los paquetes entrantes con un flujo en particular y especifica las funciones que se realizarán sobre los paquetes. Puede haber tablas de flujo múltiples que funcionan a modo de canalización. Una tabla de flujo puede dirigir un flujo a una tabla de grupos, que puede alimentar una variedad de acciones que afecten a uno o más flujos. Una tabla de medidores activa una variedad de acciones relacionadas con el rendimiento en un flujo, incluida la capacidad de limitar el tráfico. Cisco desarrolló el Application Centric Infrastructure (ACI) que es una forma más avanzada e innovadora que los enfoques SDN anteriores. Cisco ACI es una solución de hardware diseñada específicamente para integrar la computación en la nube con la administración de centros de datos. En un nivel alto, el elemento de políticas de la red se elimina del plano de datos. Esto simplifica el modo en que se crean redes del centro de datos. Los tres componentes principales de la arquitectura ACI son Application Network Profile (ANP), Application Policy Infrastructure Controller (APIC) y los switches Cisco Nexus 9000. El tejido Cisco ACI está compuesto por los switches APIC y Cisco Nexus de la serie 9000 que utilizan una topología de hoja espinal de dos niveles. En comparación con una SDN, el controlador de APIC no manipula la ruta de datos directamente. En cambio, el APIC centraliza la definición de la política y programa los switches de hoja para reenviar el tráfico en función de las políticas definidas. Existen tres tipos de SDN: SDN basada en dispositivos: los dispositivos son programables mediante aplicaciones que se ejecutan en el dispositivo mismo o en un servidor en la red. SDN basada en controladores: utiliza un controlador centralizado que tiene conocimiento de todos los dispositivos de la red. SDN basada en políticas: similar a la SDN basada en controlador, ya que un controlador centralizado tiene una vista de todos los dispositivos de la red. El SDN basado en políticas incluye una capa de políticas adicional que funciona a un nivel de abstracción mayor. Las SDN basadas en políticas son las más resistentes, lo que proporciona un mecanismo simple para controlar y administrar políticas en toda la red. Cisco APIC-EM es un ejemplo de SDN basado en políticas. Cisco APIC-EM proporciona una interfaz única para la administración de redes, que incluye el descubrimiento y acceso a inventarios de dispositivos y hosts, la visualización de la topología, el seguimiento de una ruta entre los puntos finales y el establecimiento de políticas. La herramienta APIC-EM Path Trace permite al administrador visualizar fácilmente los flujos de tráfico y descubrir cualquier entrada ACL en conflicto, duplicada o sombreada. Esta herramienta examina las ACL específicas en la ruta entre dos nodos finales y muestra todos los problemas potenciales.

ExamenRedes – Examen, preguntas y respuestas Redes De Computadores Examenes de Redes

ExamenRedes – Examen, preguntas y respuestas Redes De Computadores Examenes de Redes